Čeká nás další průmyslová revoluce? Umělá inteligence zařazuje druhý stupeň | Kapitola 3

Seznam kapitol

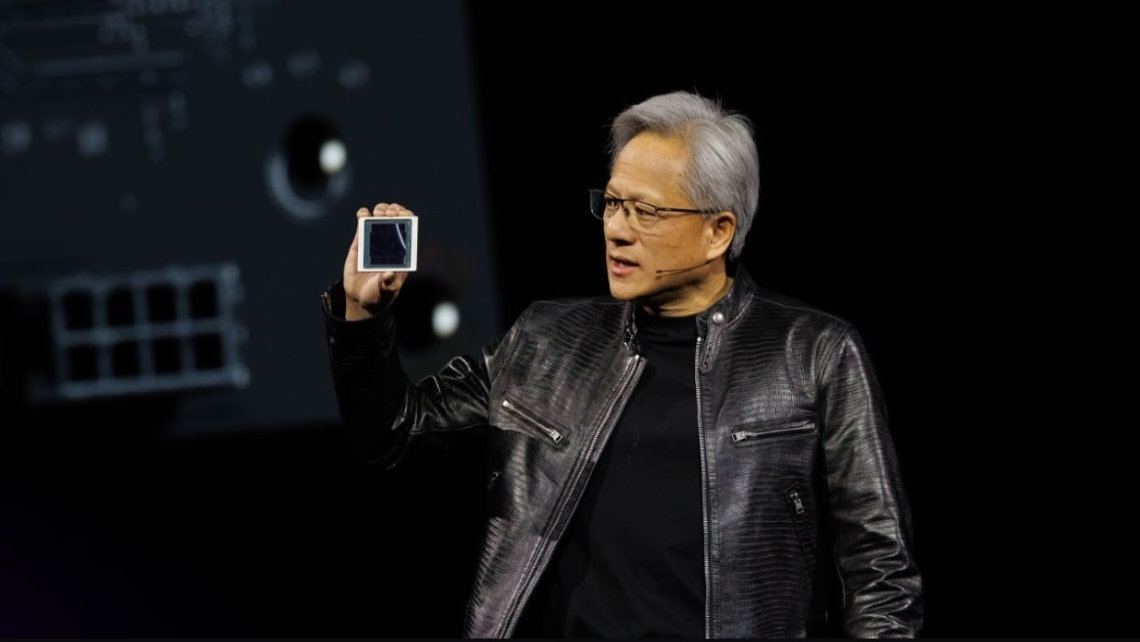

Čas od času probleskují informace o nových funkcích AI, jako jsou filmy generované nástrojem Sora. To ale není to opravdu podstatné: To podstatné je, že se dostupné technologie pro vývoj AI skokově zlepšují, ať už jde o nový superčip Cerebras WSE-3, inferenční akcelerátory Qualcomm anebo Nvidia H200 oznámená na GTC March 2024.

Mít jenom čip nestačí

Samozřejmě, obrovský čip přes celý wafer má taky svoje problémy, ze kterých Nvidia dokáže těžit – například jedna věc je mít čip a druhá věc je mít desky, které můžete osadit do racků. To je něco naprosto jiného, a pokud jsem problémy Cerebras pochopil správně, u nich jde o to najít si partnery, se kterými z toho udělají opravdové datacentrum, protože čip o velikosti waferu není snadné ani vyrobit, ani s ním manipulovat, napájet to a chladit – celá ta věc má údajně příkon 23 kW.

Všechno musí být udělané na míru a rozhodně to není čip, který byste si doma osadili do PC, protože by to nedávalo žádný smysl. Je určený pro velmi rozsáhlé učící úlohy, a tedy pro datacentra, kde tyhle potvory budou sedět – a pokud pro ně nebude práce, patrně se bude pronajímat jejich výpočetní výkon, aby se to zaplatilo. Cerebras WSE-3 je určený pro obrovské AI modely, podle údajů výrobce dokáže zvládnout modely 100× větší než ty současné a například Llama2-70B by dokázal natrénovat za jediný den.

Brutální výkon čipu Cerebras je poněkud nesmyslný pro klasickou inferenci – tam nastupuje specifické cloudové řešení od Qualcommu, Qualcomm Cloud AI 100 Ultra. Je to akcelerační zařízení v podobě rozšiřující karty PCIe Gen4 16 lanes, které obsahuje na míru udělaný procesor určený pro inferenci, tedy pro spouštění velkých generativních modelů. Obsahuje čip se 64 jádry optimalizovanými pro AI na 7 nm procesu s výkonem 870 TOPS (tera operations per second), 128 GB RAM a je schopný spouštět modely až se 100 miliardami parametrů, přičemž jde o škálovatelné řešení – dvě takové karty zvládnou modely až se 175 miliardami parametrů.

Příkon této karty je 150 W, což znamená, že jde o úspornější řešení než klasické GPU s tím, že každá karta by měla být schopná provozovat najednou 4 velké jazykové modely nebo nějakou jejich kombinaci s generativními modely. Pokud jsem to pochopil správně, tak ta věc je oznámená, je k tomu dokumentace a dá se pořídit devkit, ale finální hardware se zatím neprodává.

Zatímco procesory Cerebras jsou exotika pro speciální datacentra, tak tahle karta by se měla dát integrovat do běžné infrastruktury včetně PC, ale bude primárně určená spíš pro serverovny, takže podniky, které si budou budovat svoji AI infrastrukturu, je budou stavět s pomocí těchto akcelerátorů, které jim dovolí efektivně spouštět podobné modely.

Samozřejmě, můžete říct, že GPU je flexibilnější řešení, na kterém se dají open source modely učit i spouštět, ale jsou o něco méně efektivní a když si budete dělat svoje vlastní AI chatovací centrum pro technickou podporu anebo, co já vím, AI náhradu HR konzultační firmy (Ha! Taky na vás došlo, Catbertovi pohůnci!) Je to prostě koncové řešení pro rutinní provoz modelů AI.